Explore by Category:

Explore by Tag:

Data First Marketing

Ya son más de 10.000 marketers recibiendo ideas. ¿Te vas a quedar fuera?

¿Listo para empezar?

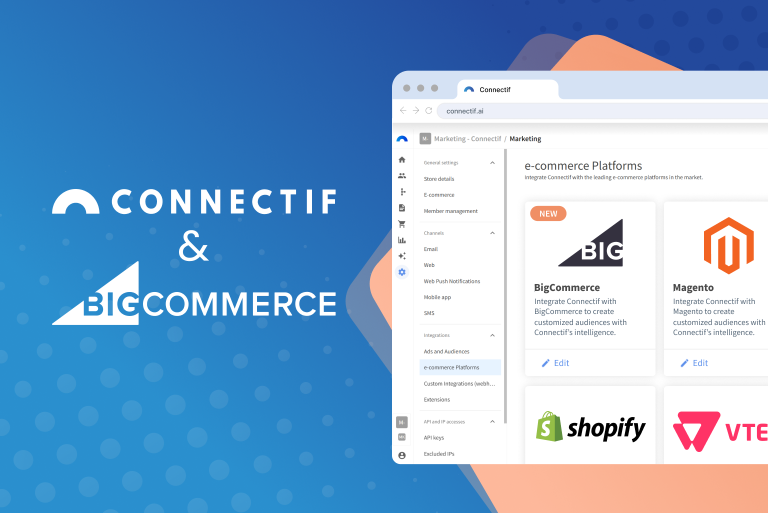

Obtén más información sobre cómo tu eCommerce puede alcanzar nuevas cotas con una plataforma de marketing automatizado todo en uno como Connectif.

Visión

Omnicanal

Seguimiento en tiempo real de todos los usuarios conocidos y anónimos en todos los canales.

Personalización

de la experiencia

Sorprende a cada uno de tus clientes con mensajes únicos y relevantes en su canal favorito.